Process Mining in Kommunen (ProM-Analysen)

Digitale Prozessanalysen mit Process Mining (Download)

Was ist Process Mining?

Digitale Prozessanalysen mit Spezialsoftware - Process Mining in Kommunen (ProM-Analysen)

Unter Process Mining (Process Mining in Kommunen (ProM-Analysen)) versteht man eine Data Mining-Methodik, die Elemente des Geschäftsprozessmanagements (Busines Process Management) und Data Mining Techniken miteinander verknüpft ("bridging the gap"-Ansatz). )

Mit Hilfe von Process Mining Techniken werden vorhandene Eventlog-Daten aus IT-Systemen extrahiert und analysiert, um Abläufe und Zusammenhänge aufzudecken (discover, deshalb "Process Discovery"), die bei einer herkömmlichen Betrachtung des Verwaltungshandelns nur mit hohem Aufwand oder gar nicht erkannt werden können.

Übergreifend betrachtet kann Process Mining in Kommunen (ProM-Analysen) das Geschäftsprozessverständnis einer Verwaltung bzw. einer Einrichtung auf drei Arten unterstützen:

1. Es hilft, Abläufe (Prozesse) zu identifizieren und dadurch besser zu verstehen (=Process Discovery),

2. Es hilft, Abäufe (Prozesse) zu überprüfen und an Vorschriften oder Änderungen anzupassen (=Process Conformance

Checking und Process Compliance) sowie

3. Es hilft, Prozessmängel zu identifizieen und Abläufe (Prozesse) zu verbessern (=Process Enhancement).

Wie funktioniert Process Mining in Kommunen (ProM-Analysen)?

Auf dem Weg hin zur Erstellung von Bescheiden oder Bearbeitung von Anträgen und Genehmigungsverfahren, die für gewöhnlich als Arbeitsergebnisse aus den Verfahren einer Verwaltung resultieren, entstehen in den nahezu flächendeckend eingesetzten IT-Systemen eine Vielzahl von Daten, darunter auch die sogenannten Log-Dateien (Protokolldateien). Sie verzeichnen, wer, wann, was im IT-System geändert hat.

So berechnet bspw. ein Fachverfahren für die Gewährung von Sozialhilfe nicht nur den Leistungsanspruch der Antragssteller/innen, sondern erzeugt auch die zur Bearbeitung gehörenden Transaktions- und Vorgangsdaten über den Zeitpunkt des Eingangs eines Antrages und den aktuellen Stand der Sachbearbeitung. Diese Informationen werden von der Software in sogenannten Ereignisprotokollen („Event Logs“) als Log-Dateien gespeichert.

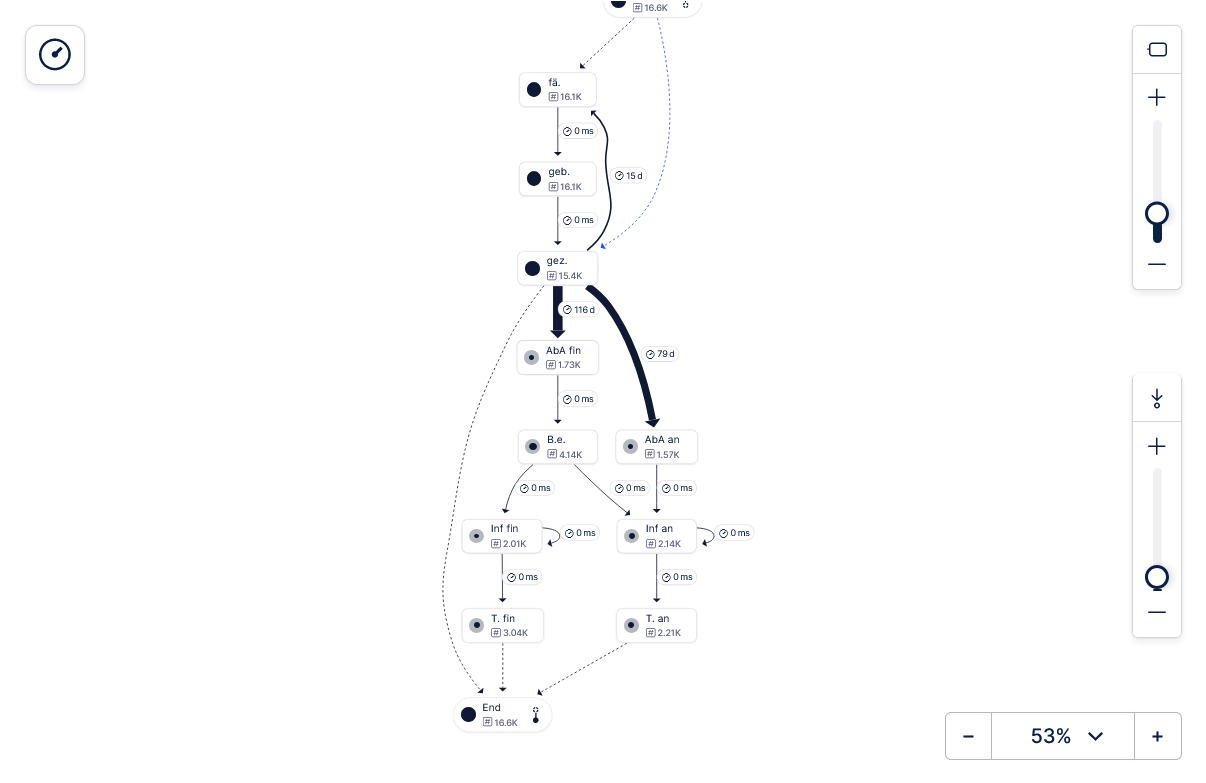

Aufgrund solcher Ereignisprotokolle hinterlässt jeder Verwaltungsvorgang im eingesetzten IT-System eine versteckte Spur aus „digitalen Brotkrumen“ in der Datenbank der Software. Diese im Laufe der Zeit aus einer Vielzahl an Verwaltungsvorgängen entstehenden Daten werden im Rahmen des Process Mining aufgegriffen, technisch aufbereitet und mithilfe von leistungsfähigen Algorithmen ausgewertet. Dies ermöglicht eine Analyse der Ereignisprotokolle, aus denen letztlich der tatsächliche Verlauf der Vorgangsbearbeitung rekonstruiert werden kann – man erhält den objektiven Geschäftsprozess zu einer Verwaltungsdienstleistung, der durch Process Mining-Software grafisch dargestellt werden kann (siehe die Abbildung oben).

Process Mining Techniken (Process Mining in Kommunen - ProM-Analysen) extrahieren und transformieren also Log-Dateien, um sie mit Spezialsoftware auf Basis hochentwickelter Algorithmen des Data Mining Umfeldes in nachvollziebare Prozessmodelle umzuwandeln und zu visualisieren. Auf Basis dieser Prozessmodelle werden dann die verschiedenen Prozessanalysen durchgeführt, beispielweise Durchlaufzeitenanalysen, Engpassanalysen und/oder Wartezeitenanalysen. Darauf aufbauend können dann wiederum Kosten- bzw. Kosten-Nutzen-Analysen prozessorientiert durchgeführt und Verbesserungsvorschläge getestet werden (z.B. durch Simulationen).)

Welche Vorteile bietet/-n Process Mining in Kommunen (ProM-Analysen)

Process Mining in Kommunen (ProM-Analysen) dienen immer der Aufdeckung und Beseitigung von Verstößen, Unwirtschaftlichkeiten und sonstigen Störungen im Geschäftsablauf. Dafür ist es in der Regel erforderlich, Prozesse zu erfassen und visuell und/oder analytisch darzustellen, z.B. durch BPMN-Modelle und Prozess-KPIs (Ermittlung von Durchlaufzeiten, Rework-Quoten, Aktivitätskosten, Varianten, Fehlentscheidungen etc.).

Process Mining in Kommunen (ProM-Analysen) bietet/n in diesem Sinne für Kommunen die Chance, ihr Geschäftsprozessmanagement aufwandsminimal auf- oder auszubauen. Neben der effektiven Nutzung von vorhandenen Prozessdaten ermöglicht Process Mining eine noch faktenbasiertere und damit objektivere Diskussion über das Verwaltungsgeschehen im Zusammenhang mit der aktuellen Aufgabenerledigung.

Process Mining in Kommunen (ProM-Analysen) kann dazu verwendet werden, bestehende Geschäftsprozesse anhand der unterstützend eingesetzten IT-Systeme zu identifizieren und für das menschliche Auge zu visualisieren, soweit bspw. keine Dokumentation der Geschäftsprozesse vorliegt. Wenn und soweit bereits eine Prozessbeschreibung vorliegt, kann mit Process Mining geprüft werden, ob die realen Vorgänge dem Prozessmodell entsprechen oder nicht. Aufwandstreibende Einzelfälle können identifiziert und deren Ursachen noch besser eingeordnet werden.

Der Vorteil ist, dass hierfür keine aufwändigen Prozesserhebungen und -messungen unter Einbindung zahlreicher Organisationseinheiten (die sich zudem untereinander selten einig sind) gebraucht werden. Vielmehr können die notwendigen Untersuchungen im Hintergrund von kleinen Projektteams und auf Grundlage einer retrospektiven Analyse der bestehenden Ist-Datenlage erfolgen (durch Auswertung der verfügbaren Log-Dateien).

Sollte es bereits eine Dokumentation der Soll-Prozesse geben, kann diese mit den durch das Process Mining festgestellten tatsächlichen Abläufen abgeglichen werden, die sich aus der Auswertung von Daten aus der eingesetzten Fachanwendung ergeben. Die Einhaltung von gesetzlichen oder internen Vorgaben kann visualisiert werden, Engpässe und Wartezeiten werden identifiziert und bewertet.

So können bspw. auch Compliance-Verstöße (z.B. bewusste Kontrollumgehungen um Dritten Vorteile zu gewähren, sog. Deviation-Analyse), verbotene Netzwerke (SNA-Analysen) oder erfundene Geschäftsvorfälle auf Basis tatsächlicher Prozessdaten schneller aufgedeckt werden (Alignment-Analysen) . Dieser Aspekt ist insbesondere für Rechnungsprüfer:innen von Vorteil.

Welche Voraussetzungen gelten für das Process Mining?

Jede Datenanalyse benötigt hochwertige nützliche Daten. So auch das Process Mining. Da die Daten in den Kommunen bekanntlich stark verteilt vorgehalten werden, z.B. in Dokumentenmanagmentsystemen, in Vorsystemen bzw. Fachanwendungen und schließlich in den zentralen ERP-Systemen für das Haushalts-, Kassen- und Rechnungswesen und dort in Haupt- und Nebenbüchern, sind die relevanten Datenquellen und der verfügbare Datenbestand vorab zu klären.

Es ist in der Regel eine Voruntersuchung oder eine förmliche Dateninventur erforderlich, um die vorhandenen relevanten Datenbestände und deren tatsächliche Verfügbarkeit zu klären. Für das Process Management werden drei Arten von Daten besonders dringend benötigt:

- Fallidentifikationsnummern (sog. "case-identifiers") zur eindeutigen Identifikation des einzelnen "Falles" im Sinne der ProM-Analyse

- Aktivitätenlisten (activities) zur eindeutigen Zuordnung einer Aktivität (=Inhalt des Änderungseintrags im IT-System) zum Fall sowie

- einheitliche Zeitstempel in einem bestimmten Format, idealerweise <tt.mm.yyyy hh:mm:ss>.

Hinzu kommen weitere Attribute wie Bearbeiter (user), Organisationseinheit, Vorgangsdatenbank, Sach- oder Personenkonten u.Ä.

Zu den Gelingensfaktoren des Projektmanagements zählen in jedem Falle eine hinreichende zeitliche Verfügbarkeit sachkundiger Personen auf den unterschiedlichen Perspektivebenen, z.B. Verwaltungsleitung und ggf. Ratsgremien (als Adressaten), Finanzen, Fachbereich und Rechenzentrum sowie ganz generell und immer die Einbindung der Personalvertretung und der/des Datenschutzbeauftragten im Vorfeld der Untersuchung. Hinsichtlich der Beschaffung oder Genehmigung einer Spezialsoftware kann eine frühzeitige Anfrage beim zuständigen Rechenzentrum sehr empfohlen werden.

Praxisbeispiele für ProM-Projekte

Stadt Leipzig (Beschaffungswesen 2021)

Stadt/Land Wien (Stadtwerke Wien Beschaffungen, übersetz aus EN von CHE-Kommunalberatung)

Stadt Lausanne (Baugenehmigungen, 2020)

5 Städte der Niederlande (Baugenehmigungen, 2015 ff.)

Kreisverwaltung NRW (Vollstreckung, 2024)

Fallstudie

Stadt Granada/Spanien (Beschwerdeverfahren, 2020)

Stadt NN (Kommunalsteuern, 2025)

ProM in

Amsterdam (Zusammenfassung in DE, übers. von CHE-Kommunalberatung)